L'A/B testing est l'une des méthodes les plus efficaces pour améliorer les taux de conversion. Faire un A/B test se révèle un élément très utile dans de nombreuses applications marketing et la mise en place d'un test est facile.

Qu'est-ce que l'A/B testing ?

L'A/B testing est une technique de marketing consistant à diffuser deux versions d'un même contenu (page de destination, e-mail ou call-to-action, par exemple) auprès de deux échantillons d'audience de taille similaire, afin de comparer les performances de chaque variante.

Sur quels éléments faire un A/B test ?

Lorsque l'entreprise souhaite optimiser sa page web ou une campagne en particulier, elle doit tester plusieurs variables présentes sur le site. Le but étant d'isoler chaque variable pour avoir des résultats concrets et mesurer au mieux l'efficacité. Voici quelques variables intéressantes à tester sur un contenu :

Les titres de pages

Modifier quelques mots ou bien le titre complet des différentes pages web peut influencer l'intérêt des internautes. Le titre est un élément qui va être aperçu en premier en arrivant sur un site. Suivant les objectifs de l'entreprise, le titre doit être rédigé en fonction, puisque c’est ce dernier qui joue son rôle de “séduction”. En effet, plus le message sera percutant et plus le taux de clic augmentera. Tester différents titres sur une page permet d'observer celui qui engage le plus les visiteurs. Afin que le titre attire davantage l'attention des prospects, l'entreprise peut également changer la couleur et la police.

La structure des pages

Les pages d'un site web doivent faire l'objet d'un soin particulier au niveau de leur structure et de la hiérarchisation des contenus. Pour cela, il existe plusieurs possibilités : modifier le bandeau, les emplacements d'éventuelles bannières publicitaires, insérer un carrousel d'images ou proposer les produits les plus intéressants sur des zones spécifiques.

Le texte

L'A/B testing apporte une aide précieuse pour définir le texte principal à utiliser sur les différents contenus web d'un site. Pour inciter les prospects à passer à l'action, il convient non seulement de présenter un texte accrocheur, mais également de réfléchir à son emplacement.

Les images

Tout comme le texte, les images occupent une place importante dans le contenu web. Ils font donc partie des éléments indispensables à tester. Il s'agit alors de travailler sur leurs dimensions, leur luminosité ou sur leur positionnement au sein de la page.

Le call-to-action

Le bouton call-to-action, ou CTA, est un ingrédient incontournable pour agir sur le taux de conversion d'une page web. Il incite les visiteurs à effectuer une action : achat, téléchargement, accès à un formulaire, inscription à une newsletter. Pour produire un maximum d'impact, il est important de jouer sur la couleur, sur l'emplacement et sur les mots utilisés dans le CTA.

Les formulaires

Un site web doit disposer d'un formulaire d'inscription à la fois clair et assez court pour être sûr de ne pas perdre l'internaute. Afin d'augmenter le taux de conversion, l'entreprise peut tester le nombre, l'emplacement et les intitulés des champs du formulaire.

Les algorithmes

L'utilisation d'algorithmes peut s'avérer bénéfique pour transformer les internautes en acheteurs, les prospects en clients. L'entreprise peut par exemple suggérer des produits à son client, les plus recherchés, les plus vendus ou les produits similaires à sa recherche initiale. La phase d'A/B testing permettra ainsi d'augmenter le panier et de fidéliser au mieux les clients.

Les prix

L'idée n'est pas de présenter les différents prix, mais plutôt de réorganiser la façon dont ils sont affichés : emplacement, police, couleur. L'entreprise peut également tester différentes offres en ligne pour tester l'impact sur le panier moyen des visiteurs.

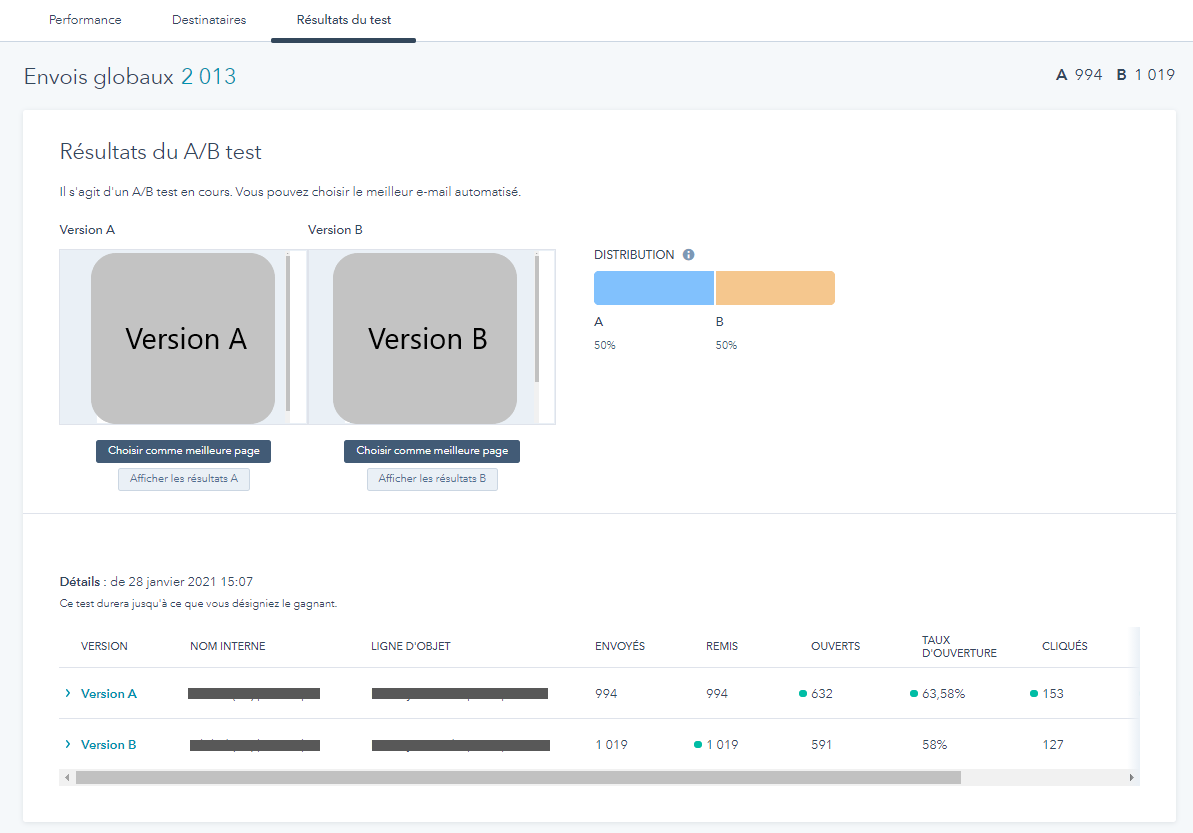

Les emails

Les phases d'A/B testing sont également cohérentes sur d'autres supports que les sites web. Une entreprise peut ainsi envoyer différents modèles d'emails pour tester la réactivité des destinataires. Les variations porteront alors sur des éléments comme :

- l'objet pour optimiser le taux d'ouverture ;

- le contenu pour augmenter le taux de clics ;

- le nom de l'expéditeur.

Comme pour l'A/B testing sur des pages web, l'important sera de pouvoir extraire des données statistiques pour ajuster les prochains envois en fonction des résultats.

La mise en page

L’A/B testing permet également de tester la mise en page des fiches produits ou des pages de vente. La mise en page peut aussi avoir un impact sur l’intérêt que va porter l'audience sur les produits. Un article bien présenté dont la description et les photos sont adaptées au format de page peut susciter et provoquer l’acte d’achat chez les internautes. Il serait aussi intéressant de tester une version avec vidéo de présentation de produit ou sans. Suivant l’emplacement des paragraphes, des images ou des titres choisis, cela peut jouer considérablement sur l’attractivité d'une page.

Le guide essentiel de l’A/B testing

Téléchargez ce guide gratuit et découvrez comment la mise en place d'un A/B testing permet d'augmenter les conversions sur votre site internet et d'optimiser l’engagement client.

- Étapes à suivre

- Conseils pour réussir

- Erreurs à éviter

- Outils à utiliser

Télécharger

Tous les champs sont obligatoires.

Merci d'avoir soumis le formulaire

Cliquez sur le lien pour accéder au contenu en tout temps

Comment faire de l'A/B testing ?

Une fois les différentes variables du site ou de la page web prises en compte, il est important de comprendre le fonctionnement d'un A/B test. Une bonne utilisation de l'A/B testing permet de prendre les bonnes décisions pour optimiser les performances du contenu.

Les 8 étapes pour créer un A/B test

1 - Sélectionner un élément à tester

L'A/B testing porte sur deux versions d'un même contenu web, lesquelles peuvent différer de manière subtile ou évidente. Il est possible de tester une seule variable, comme la couleur d'un CTA, ou un contenu complexe, comme une page entière.

Si les versions testées comportent de nombreuses différences, c'est le contenu dans son ensemble, et non ses éléments particuliers, qui doit être considéré comme la variable à interpréter. Ainsi, si le test porte sur deux versions d'une page de destination affichant chacune différents CTA, formulaires, images et titres, leurs performances comparatives ne peuvent pas être expliquées en fonction d'une seule de ces variables. Ces quatre éléments combinés doivent être envisagés comme un tout.

2 - Définir l'objectif du test et identifier les indicateurs à mesurer

La mise en place d'un A/B test nécessite de réfléchir préalablement aux objectifs visés. Il est par exemple possible d'observer comment la couleur d'un CTA influence le taux de clics. C'est là l'un des tests les plus simples à réaliser. Il peut également s'agir de vérifier si la couleur conduit les visiteurs à cliquer plus d'une fois sur le CTA.

Dans l'exemple ci-dessous, l'objectif est de rediriger autant de visiteurs que possible vers la page de destination. Ainsi, l'indicateur mesuré sera le nombre de clics.

3 - Définir la version de référence et la version test

La version de référence est l'élément A du test, soit la page de destination, l'e-mail, le call-to-action ou le titre original. La version test est l'élément B, qui comprend des modifications.

Elle représente le statu quo. La version test (B) doit donc être différente, par exemple de couleur bleue.

4 - Créer l'A/B test et le diffuser

Une fois l'objectif et les indicateurs définis, il s'agit de créer les contenus à tester. Dans cet exemple, la seule variable testée est la couleur, le texte et le design restant identiques. En effet, ce test vise à mesurer l'effet de la couleur sur le nombre de clics.

L'A/B test doit ensuite être configuré dans le logiciel marketing utilisé. Les étapes peuvent varier d'un outil et d'un type de contenu à l'autre.

5 - Promouvoir le contenu testé auprès d'un échantillon pertinent

Pour que les résultats d'un test soient statistiquement significatifs, le contenu testé doit toucher une audience relativement importante. Ainsi, un échantillon de test doit être déterminé avec soin : un e-mail doit être envoyé à une liste suffisamment longue, une page de destination peut être promue sur les réseaux sociaux et un article de blog peut bénéficier d'une campagne payante.

Si l'A/B testing porte sur une audience précise, les promotions doivent être ciblées en conséquence. Par exemple, si le test vise à évaluer la popularité d'une page de destination auprès d'abonnés Twitter, il doit être diffusé uniquement sur Twitter, et non sur Facebook ou par e-mail.

Dans l'exemple précédent, qui porte sur les conversions associées au CTA, l'article de blog doit être promu auprès de toutes les audiences susceptibles d'être intéressées.

6 - Collecter suffisamment de données

Il s'agit maintenant de faire preuve de patience. La promotion d'un test doit se poursuivre jusqu'à atteindre un seuil statistique permettant d'affirmer que les résultats sont significatifs, et non le fruit du hasard. Quelques formules mathématiques permettent de calculer ce seuil. Des outils spécifiques sont également disponibles. Une fois le seuil statistique atteint, il est possible de déterminer si la version test est plus efficace que la version de référence.

Pour obtenir des résultats statistiquement significatifs, un mois peut parfois être nécessaire pour collecter des données suffisantes. Si un test ne produit pas de résultats significatifs au bout de 30 jours, et ce malgré un trafic important, cela peut signifier que la variable testée a un impact limité. Dans ce cas, le test peut être interrompu.

7 - Élargir l'analyse à l'ensemble de l'entonnoir marketing

Une fois que les indicateurs visés ont été mesurés, l'analyse doit être élargie. Il s'agit de vérifier si le test a produit des effets sur d'autres segments de l'entonnoir.

Un élément en apparence anodin, comme la couleur d'un CTA, peut avoir des répercussions au-delà du taux de clics. Les analytics en boucle fermée permettent par exemple de vérifier si les visiteurs ayant cliqué sur le CTA se sont convertis en clients. Peut-être que le CTA bleu engendre des clients plus rapidement que la version grise.

Ce n'est probablement pas le cas dans cet exemple, mais les A/B tests plus complexes peuvent avoir de tels effets. Ainsi, examiner l'ensemble de l'entonnoir révèle parfois des résultats inattendus. Certains peuvent revêtir un intérêt commercial, tandis que d'autres peuvent remettre en question la pertinence des modifications envisagées. Il est donc important de garder à l'esprit que l'impact de l'A/B testing peut dépasser son objectif initial.

8 - Mettre les conclusions en application

Les données ont été collectées et les résultats analysés sur l'ensemble de l'entonnoir, mais le travail n'est pas terminé. Un premier A/B test ouvre souvent de nouvelles questions. Dans l'exemple, en plus de la couleur du CTA, il est possible de tester son emplacement ou son texte.

Il arrive toutefois que les résultats d'un A/B testing ne soient pas convaincants. Celui-ci a peut-être été mené au cours d'un pic de trafic saisonnier et n'est donc pas représentatif du comportement habituel des visiteurs. Dans ce cas, il est possible de répéter le test à une autre période.

Analyser un A/B test

L'analyse est une étape délicate, mais cruciale de l'A/B testing. Le recours à cette technique doit inclure une interface de reporting affichant les indicateurs suivants :

- le nombre de conversions enregistrées par variable,

- le taux de conversion,

- le pourcentage d'amélioration,

- l'indice de fiabilité statistique pour chaque variable.

Afin d'analyser le comportement des prospects et clients, il est également possible de segmenter les résultats du test A/B en différentes catégories :

- Âge,

- Zone géographique,

- Source de trafic,

- Nouveaux visiteurs,

- Nouveaux acheteurs,

- Abonnés, etc.

Ce type d'information permet de réorienter ou d'acter les futures actions marketing.

Pour analyser au mieux, l'entreprise doit également penser à mesurer la fiabilité de son test en fonction du trafic gagné par son site web. L'A/B testing est considéré comme fiable si le niveau de confiance est de 95 % et la puissance statistique d'au moins 80 % façon à l'intégrer potentiellement dans sa stratégie de growth. Il est également important d'analyser les pages qui génèrent le plus de trafic.

Les outils d'A/B testing

De nombreux outils permettent de réaliser des tests sur une page ou un site web. Voici quelques solutions intéressantes pour une campagne d'A/B testing :

- HubSpot, qui permet de réaliser des tests sur les pages de site web, les CTA, les formulaires ou les e-mails avec la version Pro du Marketing Hub.

- Google Optimize, via Google Analytics, qui permet d'effectuer gratuitement jusqu'à 10 versions de tests d'un seul contenu pour comparer leurs résultats par segmentation des utilisateurs.

- Convertize, outil d'A/B Testing disponible en français et accessible pour les personnes n'ayant pas les compétences techniques d'un webmaster. À partir de 39 € par mois, avec essai gratuit de 14 jours.

- AB Tasty, solution d'optimisation payante qui convient parfaitement aux moyennes entreprises. L'outil permet de tester le niveau d'engagement des visiteurs et d'augmenter le trafic sur le site web concerné. Tarifs non communiqués.

- Optimizely, la solution américaine la plus connue permettant de faire plusieurs expériences sur une même page. Le but de cet outil est de proposer la meilleure expérience utilisateur. Outil payant, tarifs non communiqués.

- VWO ou Visual Website Optimizer, outil proposant différentes fonctionnalités pour évaluer l'efficacité des tests A/B. À partir de 199 $ par mois, avec essai gratuit.

- Kameleoon, outil français payant permettant de faire des tests ou de personnaliser l'ensemble du contenu d'une page web dans le but de booster les conversions. Tarifs non communiqués.

Effectuer régulièrement des tests constitue un moyen efficace d'optimiser les taux de conversion de manière durable et maîtrisée.

Les bonnes pratiques pour mener un A/B testing performant

- Faire plusieurs tests

- Ne changer qu'une variable par test

- Commencer par des tests simples

- Approfondir

- Tester en continu

- Tester tous les canaux marketing

- Vérifier la valeur interprétative des résultats

- Analyse chaque résultat

- Appliquer les résultats

1 - Tester autant de variables que possible

Beaucoup de variables marketing se prêtent à l'A/B testing. Couleurs, taille, lignes d'objet, offres de contenu, modèles, mise en page, horaires ou encore fréquence d'envoi : les possibilités sont pratiquement infinies. Plus les variables testées sont nombreuses, plus les approches marketing pourront être optimisées et générer davantage de résultats.

2 - Tester une seule variable à la fois

Chaque test doit se focaliser sur une variable unique. Si les deux versions d'un call-to-action testé diffèrent tant au niveau du texte que du design, comment savoir laquelle de ces deux variables a une influence sur les performances du CTA ? Modifier une seule variable par test permet d'isoler les facteurs source d'amélioration.

3 - Commencer par des tests simples

Pour débuter avec l'A/B testing, mieux vaut se concentrer sur des éléments simples comme la couleur ou la taille d'un CTA. Avec l'expérience, il sera possible de tester des fonctionnalités plus complexes, mais même des modifications d'apparence anodine peuvent avoir un effet notable. WikiJob a par exemple conduit un A/B test qui consistait à inclure des témoignages sur une page pour favoriser les conversions. Ce simple ajout a généré 34 % de ventes supplémentaires par rapport à la page ne comportant aucun témoignage. Commencer par des tests simples permet de développer les compétences nécessaires à la conduite d'analyses plus approfondies.

4 - Approfondir au fur et à mesure

Une fois les fondamentaux de l'A/B testing maîtrisés, il est possible de conduire des comparaisons plus complexes, comme des tests A/B/C ou des tests portant sur la conception d'une page entière. Ces derniers visent à comparer deux pages au design complètement différent. Dans ce cas, la variable testée est la page dans son intégralité, et non plus ses éléments individuels.

5 - Tester en continu

Il est recommandé de conduire des tests en permanence. Si les ressources le permettent, il est possible d'effectuer différents tests en parallèle : CTA d'une page, design d'une autre page, etc. Plus les données collectées sont riches et significatives, plus il est aisé d'optimiser efficacement les activités marketing.

6 - Tester tous les canaux marketing

Tous les canaux peuvent bénéficier de l'A/B testing. Il est donc recommandé de tester l'ensemble des canaux existants, du site web à l'e-mail, en passant par le blog, les réseaux sociaux et le SEO, tout en veillant à la pertinence des indicateurs mesurés.

7 - Vérifier la valeur interprétative des résultats

Tous les tests ne produisent pas de résultats statistiquement significatifs. Une ligne d'objet peut paraître plus performante qu'une autre sans que ce constat ne soit statistiquement valable. Il est donc important de vérifier la fiabilité et la validité statistiques des observations avant de prendre des décisions.

8 - Tirer des conclusions de tous les résultats obtenus

Un test qui ne produit pas de résultats statistiquement significatifs n'est pas sans intérêt pour autant. Il peut simplement signifier que l'impact de la variable testée est négligeable. Ainsi, si la couleur d'un CTA n'a pas d'effet significatif sur le taux de clics, le texte peut quant à lui en avoir. Seul un test peut le déterminer.

9 - Appliquer les résultats des tests

Les tests sont un outil d'optimisation. Ainsi, en présence de résultats statistiquement significatifs, la variante la plus performante doit être privilégiée. Si les résultats ne permettent pas de tirer de conclusions, de nouvelles variables doivent être testées.

Pour aller plus loin, téléchargez ce guide et ce modèle gratuits et mettez en place un A/B testing efficace pour augmenter considérablement les conversions sur votre site internet et optimiser l'engagement client.

a/b testing