Pour la mise en place d'une stratégie e-mailing et comme dans toute démarche marketing, il est préférable de réaliser des tests d'optimisation des taux de conversion (CRO pour Conversion Rate Optimization).

Les tests d'optimisation peuvent cependant être complexes et, sans un minimum d'attention, il est possible de prendre des décisions susceptibles de nuire à d'autres pans de votre stratégie.

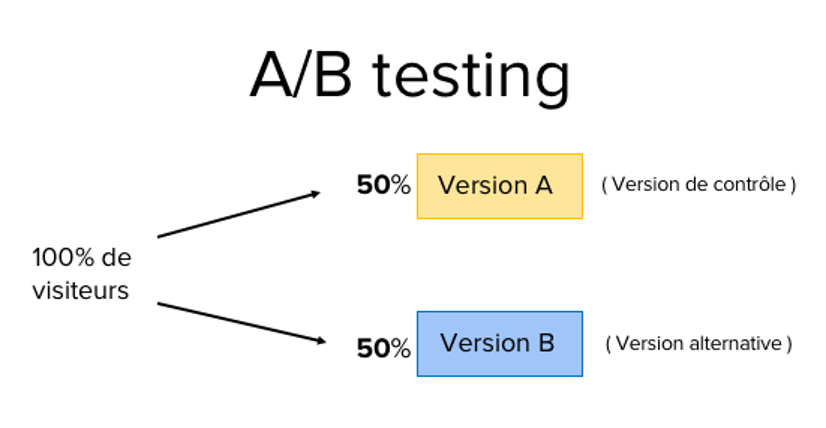

L'A/B testing constitue l'un des tests d'optimisation les plus faciles et les plus courants. Le principe est très simple : il s'agit de tester une variable d'un contenu marketing par rapport à une autre, un call-to-action vert et un rouge, par exemple, pour voir laquelle des deux est la plus performante.

Cet article propose une analyse détaillée de la marche à suivre pour mettre en place un A/B test, ainsi qu'une check-list complète des étapes qu'un marketeur devrait respecter avant, pendant et après le test. Vous pouvez ajouter cette page à vos favoris pour consultation ultérieure.

e-mailing : 7 étapes pour mettre en place l'A/B testing

- Définir le problème et les points d'amélioration.

- Fixer l'objectif à atteindre et la variable à tester.

- Créer deux versions d'e-mailing.

- Structurer deux audiences segmentées.

- Définir un seuil statistique de résultats.

- Délimiter la durée du test.

- S'appuyer sur le retour des utilisateurs.

Pour effectuer un A/B test, vous devez créer deux versions différentes d'un même contenu en ne modifiant qu'une seule variable. Vous montrerez ensuite ces deux versions à deux audiences de même taille et analyserez celle qui offre les meilleures performances.

Par exemple, si vous souhaitez savoir si le taux de conversion de votre page d'accueil augmente lorsque vous déplacez l'un des CTA du menu latéral au sommet de la page, créez une page web alternative reflétant le nouveau placement du CTA. La version existante, ou version de contrôle, constitue la variation A, tandis que la variation B représente la version alternative.

Pour tester ces deux variations, vous les présenterez ensuite à un pourcentage prédéfini de visiteurs.

Pour générer des résultats représentatifs qui peuvent informer vos décisions, il faut minutieusement planifier votre test.

Définir le problème et les points d'amélioration

La démarche de l'A/B testing en elle-même repose sur un problème, identifié généralement par une analyse de données. Ensuite, des préconisations ou points d'amélioration potentiels sont définis pour mettre en place la comparaison avec la version originale.

Après la phase d'identification, le problème doit être décrit afin d'être compris par toutes les personnes qui interviendront dans l'A/B test. Il est important d'ajouter des précisions sur la nature du problème :

- Son périmètre.

- Son incidence sur la stratégie.

- Son niveau d'importance.

- Etc.

Fixer l'objectif à atteindre et la variable à tester

Pour évaluer l'efficacité d'un changement, vous devez isoler une seule variable et en mesurer la performance. Si vous en choisissez plusieurs, vous ne pourrez pas déterminer celle qui a une incidence sur les performances. Vous pouvez tester plusieurs variables d'une page ou d'un e-mail, mais vous devez faire en sorte de n'en tester qu'une seule à la fois.

Étudiez les différents éléments de vos ressources marketing et leurs alternatives possibles en matière de design, de formulation et de présentation. Les objets d'e-mails, les noms d'expéditeurs et les différentes options de personnalisation de vos e-mails peuvent également faire l'objet de tests.

Gardez à l'esprit que même les modifications les plus simples, telles qu'une image dans un e-mail ou la formulation d'un call-to-action, peuvent entraîner des améliorations conséquentes. En outre, l'impact de ce genre de modifications est souvent plus simple à mesurer que celui de changements de plus grande envergure.

Note : il est parfois plus pertinent de tester plusieurs variables plutôt qu'une seule lors d'un test multivarié.

Pour renforcer la pertinence de l'A/B test, il est conseillé de se focaliser sur un indicateur principal, et ce, même si vous souhaitez par la suite vous appuyer sur plusieurs indicateurs par test. Définissez votre indicateur principal avant de configurer la seconde variante du test.

Créer deux versions d'e-mailing

La version non modifiée de l'élément que vous testez constitue la version de contrôle. Si vous choisissez de tester la page de destination de votre e-mail marketing, il faut conserver la mise en page et du contenu que vous utilisez habituellement.

Une fois la version de contrôle définie, vous pouvez créer une variante ou une alternative à savoir l'e-mail marketing que vous souhaitez comparer à votre version de contrôle.

Par exemple, si vous souhaitez savoir si l'intégration d'un témoignage client sur une page de destination apporterait des résultats différents, configurez votre page de contrôle sans témoignage. Créez ensuite votre variante avec un témoignage.

Le timing de votre test joue un rôle prépondérant dans les résultats de votre campagne marketing. Si vous deviez tester la version A pendant un mois et la version B le mois suivant, vous seriez incapable de déterminer quel facteur altère les performances de la ressource testée.

Lorsque vous réalisez des A/B tests, vous devez tester les deux variantes simultanément, faute de quoi vos résultats manqueront de fiabilité.

Tester le timing lui-même, par exemple pour déterminer le meilleur horaire pour envoyer un e-mail, constitue la seule exception à cette règle. Cette variable est particulièrement intéressante, car en fonction de ce qu'offre votre entreprise et de vos abonnés, l'horaire optimal pour susciter leur engagement peut varier de manière significative d'un secteur d'activité et d'un marché cible à l'autre.

Structurer deux audiences segmentées

Les tests d'e-mails doivent être effectués auprès de deux audiences égales ou plus pour obtenir des résultats concluants.

La méthode employée dépendra de l'outil d'A/B testing utilisé. Si vous avez accès à la version Entreprise de HubSpot Marketing et que vous effectuez un A/B test sur un e-mail, par exemple, le trafic sera réparti automatiquement entre les deux variantes afin qu'elles soient diffusées auprès d'un échantillon aléatoire de visiteurs.

La méthode que vous emploierez pour déterminer ce facteur dépendra également de votre outil d'A/B testing et du type d'A/B test réalisé.

Sur un e-mail, il est préférable de réaliser un A/B test auprès d'une petite portion de votre liste pour obtenir des données statistiquement significatives. Vous pourrez alors choisir la variante qui génère les meilleurs résultats et l'envoyer au reste de la liste.

La solution e-mailing de HubSpot vous permet de déterminer la taille de votre échantillon à l'aide d'un curseur. Vous pouvez assurer la distribution de votre test auprès d'un échantillon scindé en deux audiences égales, quelle que soit sa taille. En revanche, il devra compter au moins 1 000 destinataires si vous optez pour une répartition différente.

Si vous testez un élément qui n'a pas d'audience définie, comme une page web, la durée du test a une incidence directe sur la taille de votre échantillon. Vous devrez exécuter le test suffisamment longtemps pour obtenir un nombre conséquent de vues, faute de quoi vous ne pourrez pas déterminer avec certitude la différence de résultats entre les deux variantes.

Définir un seuil statistique de résultats

Une fois que vous avez choisi votre indicateur, la définition d'un seuil statistique permet de justifier le choix de la variante sélectionnée.

Concrètement, plus le pourcentage de votre niveau de confiance est élevé, plus vous pouvez être sûr de vos résultats. Dans la plupart des cas, un niveau de confiance de 95 % minimum, voire 98 %, est attendu, surtout si le processus de mise en place a été chronophage. Cependant, vous pouvez également utiliser un indice de confiance moins élevé si vous effectuez des tests moins précis.

Le seuil statistique est parfois comparé à un pari où il s'agit de décider de la mise que vous souhaitez placer. Avoir confiance à 80 % que la version gagnante présente le meilleur design et tout miser dessus revient à réaliser un A/B test à un seuil de 80 % et à choisir un gagnant.

Le choix d'un seuil de confiance plus élevé est souvent préférable lorsqu'une variable qui n'améliore que légèrement le taux de conversion est testée. La variante aléatoire est alors susceptible de jouer un plus grand rôle.

Il serait par exemple plus sûr de baisser le seuil de confiance dans le cas d'une expérience qui augmentera probablement le taux de conversion de 10 % ou plus, comme pour une section témoignages remaniée.

En bref, plus le changement à prévoir est spécifique (couleur d'un bouton, petit extrait de texte, etc.), moins l'impact sur le taux de conversion sera important. Il convient alors dans ce cas d'adopter une approche scientifique.

Délimiter la durée du test

Votre test doit se dérouler sur une période suffisamment longue pour vous permettre d'obtenir un échantillon assez important.

Déterminer la durée d'un test peut se révéler plus complexe qu'il n'y paraît. Selon votre entreprise et le mode d'exécution de l'A/B test, quelques heures, quelques jours ou plusieurs semaines peuvent être nécessaires pour pouvoir tirer une conclusion valide.

Le volume de trafic que vous générez constitue l'un des principaux facteurs entrant en ligne de compte. Si le trafic vers le site web de votre entreprise n'est pas élevé, l'A/B test sera plus long à exécuter.

S'appuyer sur le retour des utilisateurs

L'A/B testing est surtout une question de données quantitatives, mais cela ne vous aide pas nécessairement à comprendre pourquoi les utilisateurs effectuent certaines actions plutôt que d'autres. Lorsque vous effectuez un A/B test, pensez à recueillir les commentaires des audiences ciblées.

L'enquête ou le sondage représente l'un des meilleurs moyens de questionner les habitudes des utilisateurs. Ajoutez une enquête sur votre site pour demander aux visiteurs pourquoi ils n'ont pas cliqué sur un certain CTA, ou sur vos pages de remerciement pour leur demander pourquoi ils ont cliqué sur un bouton ou rempli un formulaire.

Vous découvrirez alors peut-être qu'un grand nombre d'utilisateurs ont a cliqué sur un call-to-action les redirigeant vers un e-book, mais qu'ils ne se sont pas convertis en raison de son prix. Ce genre d'informations vous permettra de comprendre le parcours type de vos utilisateurs.

Pour aller plus loin, découvrez comment réussir à coup sûr vos messages en téléchargeant le guide pour rédiger un e-mail professionnel ; ou découvrez la boîte de réception partagée de HubSpot.

Comment faire de l'A/B testing en e-mail marketing ?

GUIDE POUR RÉDIGER SES E-MAILS

Comment rédiger un e-mail professionnel réussi ?

Télécharger gratuitementMis à jour :

Pour la mise en place d'une stratégie e-mailing et comme dans toute démarche marketing, il est préférable de réaliser des tests d'optimisation des taux de conversion (CRO pour Conversion Rate Optimization).

Les tests d'optimisation peuvent cependant être complexes et, sans un minimum d'attention, il est possible de prendre des décisions susceptibles de nuire à d'autres pans de votre stratégie.

L'A/B testing constitue l'un des tests d'optimisation les plus faciles et les plus courants. Le principe est très simple : il s'agit de tester une variable d'un contenu marketing par rapport à une autre, un call-to-action vert et un rouge, par exemple, pour voir laquelle des deux est la plus performante.

Cet article propose une analyse détaillée de la marche à suivre pour mettre en place un A/B test, ainsi qu'une check-list complète des étapes qu'un marketeur devrait respecter avant, pendant et après le test. Vous pouvez ajouter cette page à vos favoris pour consultation ultérieure.

e-mailing : 7 étapes pour mettre en place l'A/B testing

Pour effectuer un A/B test, vous devez créer deux versions différentes d'un même contenu en ne modifiant qu'une seule variable. Vous montrerez ensuite ces deux versions à deux audiences de même taille et analyserez celle qui offre les meilleures performances.

Par exemple, si vous souhaitez savoir si le taux de conversion de votre page d'accueil augmente lorsque vous déplacez l'un des CTA du menu latéral au sommet de la page, créez une page web alternative reflétant le nouveau placement du CTA. La version existante, ou version de contrôle, constitue la variation A, tandis que la variation B représente la version alternative.

Pour tester ces deux variations, vous les présenterez ensuite à un pourcentage prédéfini de visiteurs.

Pour générer des résultats représentatifs qui peuvent informer vos décisions, il faut minutieusement planifier votre test.

Définir le problème et les points d'amélioration

La démarche de l'A/B testing en elle-même repose sur un problème, identifié généralement par une analyse de données. Ensuite, des préconisations ou points d'amélioration potentiels sont définis pour mettre en place la comparaison avec la version originale.

Après la phase d'identification, le problème doit être décrit afin d'être compris par toutes les personnes qui interviendront dans l'A/B test. Il est important d'ajouter des précisions sur la nature du problème :

Fixer l'objectif à atteindre et la variable à tester

Pour évaluer l'efficacité d'un changement, vous devez isoler une seule variable et en mesurer la performance. Si vous en choisissez plusieurs, vous ne pourrez pas déterminer celle qui a une incidence sur les performances. Vous pouvez tester plusieurs variables d'une page ou d'un e-mail, mais vous devez faire en sorte de n'en tester qu'une seule à la fois.

Étudiez les différents éléments de vos ressources marketing et leurs alternatives possibles en matière de design, de formulation et de présentation. Les objets d'e-mails, les noms d'expéditeurs et les différentes options de personnalisation de vos e-mails peuvent également faire l'objet de tests.

Gardez à l'esprit que même les modifications les plus simples, telles qu'une image dans un e-mail ou la formulation d'un call-to-action, peuvent entraîner des améliorations conséquentes. En outre, l'impact de ce genre de modifications est souvent plus simple à mesurer que celui de changements de plus grande envergure.

Note : il est parfois plus pertinent de tester plusieurs variables plutôt qu'une seule lors d'un test multivarié.

Pour renforcer la pertinence de l'A/B test, il est conseillé de se focaliser sur un indicateur principal, et ce, même si vous souhaitez par la suite vous appuyer sur plusieurs indicateurs par test. Définissez votre indicateur principal avant de configurer la seconde variante du test.

Créer deux versions d'e-mailing

La version non modifiée de l'élément que vous testez constitue la version de contrôle. Si vous choisissez de tester la page de destination de votre e-mail marketing, il faut conserver la mise en page et du contenu que vous utilisez habituellement.

Une fois la version de contrôle définie, vous pouvez créer une variante ou une alternative à savoir l'e-mail marketing que vous souhaitez comparer à votre version de contrôle.

Par exemple, si vous souhaitez savoir si l'intégration d'un témoignage client sur une page de destination apporterait des résultats différents, configurez votre page de contrôle sans témoignage. Créez ensuite votre variante avec un témoignage.

Le timing de votre test joue un rôle prépondérant dans les résultats de votre campagne marketing. Si vous deviez tester la version A pendant un mois et la version B le mois suivant, vous seriez incapable de déterminer quel facteur altère les performances de la ressource testée.

Lorsque vous réalisez des A/B tests, vous devez tester les deux variantes simultanément, faute de quoi vos résultats manqueront de fiabilité.

Tester le timing lui-même, par exemple pour déterminer le meilleur horaire pour envoyer un e-mail, constitue la seule exception à cette règle. Cette variable est particulièrement intéressante, car en fonction de ce qu'offre votre entreprise et de vos abonnés, l'horaire optimal pour susciter leur engagement peut varier de manière significative d'un secteur d'activité et d'un marché cible à l'autre.

Structurer deux audiences segmentées

Les tests d'e-mails doivent être effectués auprès de deux audiences égales ou plus pour obtenir des résultats concluants.

La méthode employée dépendra de l'outil d'A/B testing utilisé. Si vous avez accès à la version Entreprise de HubSpot Marketing et que vous effectuez un A/B test sur un e-mail, par exemple, le trafic sera réparti automatiquement entre les deux variantes afin qu'elles soient diffusées auprès d'un échantillon aléatoire de visiteurs.

La méthode que vous emploierez pour déterminer ce facteur dépendra également de votre outil d'A/B testing et du type d'A/B test réalisé.

Sur un e-mail, il est préférable de réaliser un A/B test auprès d'une petite portion de votre liste pour obtenir des données statistiquement significatives. Vous pourrez alors choisir la variante qui génère les meilleurs résultats et l'envoyer au reste de la liste.

La solution e-mailing de HubSpot vous permet de déterminer la taille de votre échantillon à l'aide d'un curseur. Vous pouvez assurer la distribution de votre test auprès d'un échantillon scindé en deux audiences égales, quelle que soit sa taille. En revanche, il devra compter au moins 1 000 destinataires si vous optez pour une répartition différente.

Si vous testez un élément qui n'a pas d'audience définie, comme une page web, la durée du test a une incidence directe sur la taille de votre échantillon. Vous devrez exécuter le test suffisamment longtemps pour obtenir un nombre conséquent de vues, faute de quoi vous ne pourrez pas déterminer avec certitude la différence de résultats entre les deux variantes.

Définir un seuil statistique de résultats

Une fois que vous avez choisi votre indicateur, la définition d'un seuil statistique permet de justifier le choix de la variante sélectionnée.

Concrètement, plus le pourcentage de votre niveau de confiance est élevé, plus vous pouvez être sûr de vos résultats. Dans la plupart des cas, un niveau de confiance de 95 % minimum, voire 98 %, est attendu, surtout si le processus de mise en place a été chronophage. Cependant, vous pouvez également utiliser un indice de confiance moins élevé si vous effectuez des tests moins précis.

Le seuil statistique est parfois comparé à un pari où il s'agit de décider de la mise que vous souhaitez placer. Avoir confiance à 80 % que la version gagnante présente le meilleur design et tout miser dessus revient à réaliser un A/B test à un seuil de 80 % et à choisir un gagnant.

Le choix d'un seuil de confiance plus élevé est souvent préférable lorsqu'une variable qui n'améliore que légèrement le taux de conversion est testée. La variante aléatoire est alors susceptible de jouer un plus grand rôle.

Il serait par exemple plus sûr de baisser le seuil de confiance dans le cas d'une expérience qui augmentera probablement le taux de conversion de 10 % ou plus, comme pour une section témoignages remaniée.

En bref, plus le changement à prévoir est spécifique (couleur d'un bouton, petit extrait de texte, etc.), moins l'impact sur le taux de conversion sera important. Il convient alors dans ce cas d'adopter une approche scientifique.

Comment rédiger un email professionnel réussi ?

Grâce à ce guide, découvrez les astuces à suivre ainsi que la structure d'un e-mail réussi et adapté.

Télécharger

Tous les champs sont obligatoires.

Merci d'avoir soumis le formulaire

Cliquez sur le lien pour accéder au contenu en tout temps

Délimiter la durée du test

Votre test doit se dérouler sur une période suffisamment longue pour vous permettre d'obtenir un échantillon assez important.

Déterminer la durée d'un test peut se révéler plus complexe qu'il n'y paraît. Selon votre entreprise et le mode d'exécution de l'A/B test, quelques heures, quelques jours ou plusieurs semaines peuvent être nécessaires pour pouvoir tirer une conclusion valide.

Le volume de trafic que vous générez constitue l'un des principaux facteurs entrant en ligne de compte. Si le trafic vers le site web de votre entreprise n'est pas élevé, l'A/B test sera plus long à exécuter.

S'appuyer sur le retour des utilisateurs

L'A/B testing est surtout une question de données quantitatives, mais cela ne vous aide pas nécessairement à comprendre pourquoi les utilisateurs effectuent certaines actions plutôt que d'autres. Lorsque vous effectuez un A/B test, pensez à recueillir les commentaires des audiences ciblées.

L'enquête ou le sondage représente l'un des meilleurs moyens de questionner les habitudes des utilisateurs. Ajoutez une enquête sur votre site pour demander aux visiteurs pourquoi ils n'ont pas cliqué sur un certain CTA, ou sur vos pages de remerciement pour leur demander pourquoi ils ont cliqué sur un bouton ou rempli un formulaire.

Vous découvrirez alors peut-être qu'un grand nombre d'utilisateurs ont a cliqué sur un call-to-action les redirigeant vers un e-book, mais qu'ils ne se sont pas convertis en raison de son prix. Ce genre d'informations vous permettra de comprendre le parcours type de vos utilisateurs.

Pour aller plus loin, découvrez comment réussir à coup sûr vos messages en téléchargeant le guide pour rédiger un e-mail professionnel ; ou découvrez la boîte de réception partagée de HubSpot.

Email marketing

Logiciel emailing gratuit

Partager cet article sur les réseaux sociaux

Articles recommandés

Méthode AIDA : définition, utilisation et exemple

Comment faire de l'e-mail marketing en B2B ?

Emailing : 12 KPI à suivre (avec formule et exemple)

Bannière pour l'en-tête d'e-mail : comment faire et quels outils utiliser ?

Qu'est-ce que le taux d'ouverture en emailing ?

Email marketing : qu'est-ce que c'est ?

Campagnes d'opt-out : encourager le désabonnement aux e-mails marketing

10 e-mails post-achat importants à connaître pour fidéliser sa clientèle

Double opt-in : définition et fonctionnement

Soft bounce et hard bounce : qu'est-ce que c'est ?